Wenn ihr samarbeid für viele tägliche Arbeitsabläufe nutzt, dann entsteht Schritt für Schritt euer organisationales Gedächtnis. In samarbeid sind dann alle Daten zu euren Arbeitsabläufen (Wer hat wann in welchen Prozessen was gemacht?) und zu euren Arbeitsergebnissen (Daten und Dokumente in den Aufgaben und Dossiers) gespeichert. Und natürlich sind all diese Informationen bei der weiteren Arbeit hilfreich und wichtig. Nur müsst ihr sie schnell finden, wenn sie gebraucht werden. Je mehr ihr in samarbeid arbeitet, desto mehr Daten werden gespeichert. Und: desto schwieriger kann es für euer Team werden, die relevanten Informationen zu finden. Warum sind Sprachmodelle dafür relevant?

Braucht es dafür nicht einfach eine bessere Volltextsuche? Vielleicht. Aber wäre es nicht viel besser, wenn samarbeid auf eure Fragen direkte Antworten gibt? Und dann noch genau basierend auf all den privaten Daten, die in samarbeid in euren Prozessen, Aufgaben und Dossiers schon gespeichert sind? Dank der Nutzung von Sprachmodellen ist das in Kombination mit Retrieval-Augmented Generation (RAG) möglich. Und nicht erst in Zukunft, sondern bereits heute. Im folgenden wollen wir euch zeigen, wie wir derzeit mit KI experimentieren, um samarbeid intelligenter zu machen – und was das zukünftig für euch bedeutet kann.

Was ist RAG? (Und warum ist es so mächtig für samarbeid?)

Große Sprachmodelle (Large Languages Models, kurz: LLMs) wie ChatGPT sind stark darin, das Wissen zu verarbeiten, mit dem sie trainiert sind. Das reicht für sehr viele Anwendungsfälle aus. Doch was macht ihr, wenn ihr private Daten aus eurer Organisation verarbeiten möchtet? ChatGPT kennt natürlich nicht die Vertriebskennzahlen aus dem letzten Quartal und du auch nicht die Beschwerde-Mail eines Lieferanten. Wenn ihr eine maßgeschneiderte Antwort-Mail auf Basis eurer Kennzahlen erhalten wollt, müsst ihr in eurem Prompt diese privaten Daten als als zusätzliche Information an ChatGPT senden.

Ungefähr so funktioniert auch Retrieval-Augmented Generation (RAG). Damit werden große Sprachmodelle verbessert, indem bei der Anfrage zusätzlich relevante (und somit private) Informationen als Kontext mitgeliefert werden. Die Modelle generieren dann die Antwort auf Basis des mitgelieferten Kontexts in Kombination mit ihrem allgemeinen Weltwissen. Häufig ist das folgendermaßen umgesetzt: Anstatt sich auf vortrainiertes Wissen zu verlassen, werden die passenden privaten Daten aus einem System wie samarbeid abgerufen und zu einem Kontext zusammengestellt. Das wird alles an das Sprachmodell gesendet, was so präzisere Antworten geben kann.

Der große Vorteil von samarbeid bei diesem Ansatz: samarbeid ist euer organisationales Gedächtnis, es verknüpft bereits verwandte Datenpunkte durch Dossiers, Aufgaben und Kommentare. Diese strukturierte Datenbasis ermöglicht es, Prompts – also Anfragen an das Sprachmodell – mit einem präzisen und sinnvollen Kontext zu versehen.

Allerdings bedeutet der RAG-Ansatz auch, dass eure sensiblen, privaten Daten an den Betreiber des Sprachmodells gesendet werden. Das gilt es natürlich zu vermeiden. Daher haben wir uns auf die Suche gemacht, ob es auch Open-Source-Lösungen gibt. Das macht in Zukunft KI-Features in samarbeid möglich, ohne dass ihr die gewohnte Souveränität über eure Prozesse und Daten verliert.

Erste Experimente: samarbeid goes LLM (Sprachmodelle)

Bei dieser Suche standen für uns zwei Fragen im Raum. Die grundsätzlichste Frage ist natürlich, ob der RAG-Ansatz in Kombination mit samarbeid überhaupt funktioniert. Gleich darauf folgt die Frage, ob die derzeit verfügbaren Open-Source-Sprachmodelle ausreichend gut sind – und welches davon am Besten ist.

Um diese Fragen zu beantworten haben wir experimentiert. Dabei sind wir in den folgenden Schritten gefolgt:

- Wir habe ein feste Liste von Fragen erstellt, um die Ergebnisse der verschiedenen Sprachmodelle besser vergleichen zu können.

- Unser samarbeid-Team nutzt natürlich auch samarbeid zur Organisation unserer Arbeitsabläufe. Wir haben einen Snapshot der Datenbank unserer eigenen samarbeid-Instanz genommen, um die Vergleiche konsistent zu halten.

- Wir haben verschiedene Methoden zur Kontextbeschaffung getestet, denn in der intelligenten Zusammenstellung des mitgelieferten Kontexts liegt die Kunst des RAG-Ansatzes.

- Wir haben verfügbare Open-Source-Sprachmodelle evaluiert und die für uns spannendsten in unsere Experimentierumgebung aufgenommen.

Verschiedene Ansätze zur Kontextbeschaffung

In der Bereitstellung des richtigen Kontexts liegt die große Kunst des RAG-Ansatzes. Denn ihr könnt immer nur einen begrenzten Kontext bei den Anfragen mitschicken. Je größer das Modell, desto mehr Daten könnt ihr als Kontext nutzen. Jedoch ist der Kontext immer kleiner als die Datenmenge, die in samarbeid gespeichert ist. Daher braucht es auch in Zukunft intelligente Methoden, um den passenden Kontext für eine Anfrage aus der Datenbasis von samarbeid zu extrahieren.

In unseren Experimenten haben wir dabei zwei verschiedene Methoden ausprobiert:

- Volltextsuche – Wir haben die eingebaute Suchfunktion in samarbeid genutzt, um relevante Textausschnitte zu finden. Dazu haben wir die Anfrage an das Sprachmodell auch an die Volltextsuche in samarbeid geschickt und die obersten Ergebnisse als Kontext mitgesendet.

- Dossier-zentrierte Suche – Im Kontext unserer Experimente haben wir die Anfragen an das Sprachmodell immer im Kontext eines bestimmten Dossiers gemacht. Dadurch konnten wir die innere Struktur von samarbeid nutzen, um einen passgenauen Kontext aus dem Dossier und seinem Umfeld zu generieren. In unseren Experimenten haben wir dabei folgenden Daten als Kontext genutzt:

- die Strukturdaten des Dossiers und den Inhalt aller Datenfelder des Dossiers

- alle Kommentare im Dossier

- alle Kommentare an anderen Stelle in samarbeid, in denen das Dossier referenziert wird

- Textfelder in Aufgaben oder anderen Dossiers, in denen auf das Dossier referenziert wird

- Aufgaben, in denen das Dossier explizit über ein Datenfeld (Dossierreferenz) referenziert wird.

In unseren Experimenten hat sich gezeigt, dass beide Ansätze ihre Stärken und Schwächen haben – oft ergab eine Kombinationen die besten Ergebnisse. Wir stehen hier noch am Anfang des Finetuning und haben eine Menge Ideen, wie wir die Kontextgenerierung verbessern können. Dank unserer Experimente wissen wir, dass die Richtung stimmt.

Vergleich verschiedener LLMs (Sprachmodelle)

Da uns eure Datensouveränität sehr am Herzen liegt, konzentrieren wir uns auf Open-Source-Sprachmodelle. Diese können – die notwendigen Ressourcen vorausgesetzt – lokal betrieben werden. Oder ihr nutzt einen Dienst, bei dem diese Modelle privat in einem pay-per-use Modell eingesetzt werden können. Beides ist heute noch relativ teuer – aber die Entwicklung im Bereich der Sprachmodelle geht rasend schnell und damit sinken die Kosten immer mehr.

Dank des Einsatzes von Open-Source-Sprachmodellen könnt wir zukünftig die Souveränität über eure privaten Daten, die im Rahmen des RAG-Ansatzes dem Sprachmodell übergeben werden, auch beim Einsatz von KI behalten. Daher ist es unser Ziel, ein Open-Source-Modell zu finden, das gute Antworten liefert und gleichzeitig praktikabel für den Einsatz in kleineren Organisationen ist. Denn die meisten von euch, die samarbeid einsetzen, tun dies in kleineren Organisationen mit engen Budgets.

Am Ende haben wir uns die folgenden drei Modelle im Detail angeschaut:

- Llama 3.1 8B (klein, effizient, aber begrenzter Kontext)

- Llama 3.1 405B (sehr groß, liefert detaillierte Antworten)

- Llama 3.3 70B (deutlich kleiner als 405B, aber leistungsfähig und praktisch für lokale Nutzung)

Wichtig: Obwohl Llama von Meta veröffentlicht wurde, ist es ein Open-Source-Sprachmodell. Es ist trainiert von Meta, aber man kann es herunterladen und selbst nutzen. Wenn ihr Llama selbst nutzt, dann läuft das vollständig privat und es fließen keinerlei Daten an Meta ab. Ihr behaltet die Souveränität über eure privaten Daten.

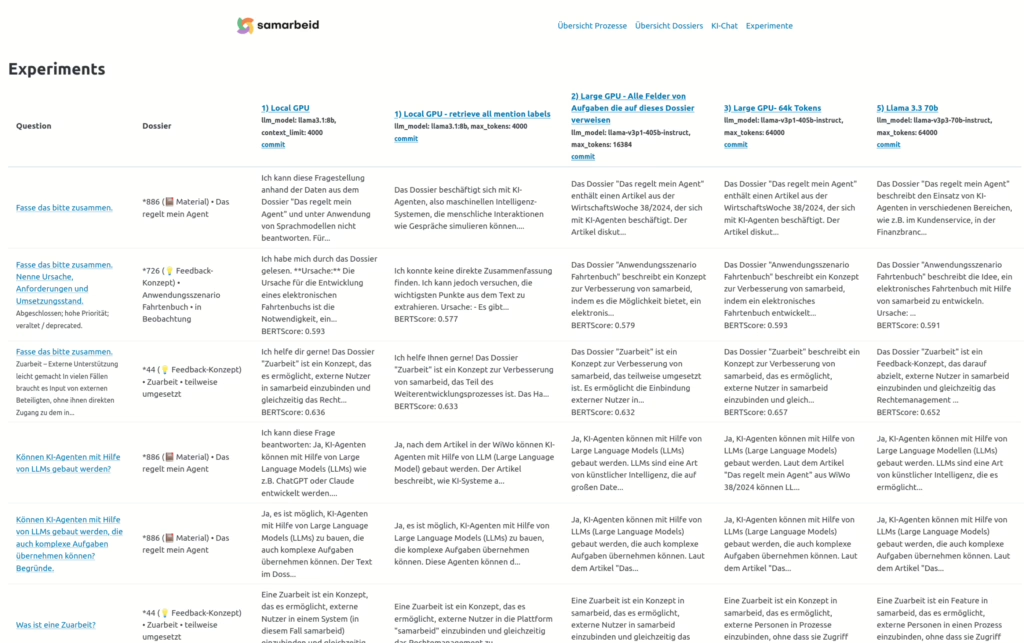

In der folgenden Abbildung bekommt ihr einen kleinen Einblick über das Set-Up unserer KI-Experimente.

Das Sprachmodell Llama plaudert mit samarbeid

Und wie könnt ihr euch jetzt die Ergebnisse vorstellen? Dazu haben wir hier ein paar Beispiele zusammengestellt, bei der wir die Datenbank der samarbeid-Instanz unseres eigenen Teams genutzt haben.

In unserem Team-samarbeid haben wir ein Dossier, in dem wir alle Ideen rund um die Konzeption bei der Entwicklung der Zuarbeiten dokumentiert haben. Dieses Dossier ist eine lose Sammlung von Kommentaren und Textfeldern. Und natürlich haben wir auch in anderen Dossiers und Aufgaben über die Konzeptionsarbeit rund um die Zuarbeit gesprochen. Immer dann haben wir das Dossier referenziert – so dass auch diese Informationen in die Generierung des Kontext mit einfließen. Dann haben wir die Aufforderung: “Fasse das bitte zusammen.” an die verschiedenen Modelle gesendet. Und haben die folgenden Antworten erhalten:

Llama 3.1 8B “Das Dossier “Zuarbeit” ist ein Konzept, das es ermöglicht, externe Nutzer in samarbeid einzubinden und gleichzeitig das Rechtemanagement zu verschlanken. Der Hauptvorteil dieses Konzepts besteht darin, dass man Stundenzettel von mehreren WHKs (Work Hours Keeper) ohne Datenschutzprobleme organisieren kann. Das Konzept der Zuarbeit wurde bereits in verschiedenen Diskussionen und Issues bestätigt, z.B. in #527, #571 und %207. Es ist auch im strategischen Ziel “Flexibles System” enthalten. Aktuell steht das Projekt “Zuarbeit” noch in der teilweisen Umsetzung, es gibt jedoch bereits erste positive Ergebnisse. Zum Beispiel kann man mit dieser Funktion externe Nutzer in samarbeid einbinden und ihnen bestimmte Aufgaben zuweisen, ohne dass sie gleichzeitig alle anderen Inhalte sehen müssen.”

Kleiner Fun-Fact am Rande: WHK sind bei uns Wissenschaftliche Hilfskräfte – und nicht wie vom Modell spontan geraten Work Hours Keerpers.

Llama 3.1 405B (64k Tokens) “Das Dossier “Zuarbeit” ist ein Konzept zur Verbesserung von samarbeid, das teilweise umgesetzt ist. Es ermöglicht die Einbindung externer Nutzer in samarbeid und verschlankt das Rechtemanagement. Ein valider Anwendungsfall ist das Zusammensammeln von Stundenzetteln von mehreren WHKs. Das Konzept der Zuarbeit wurde auch in anderen Kontexten diskutiert, wie z.B. als Grundlage für einen Freigabemechanismus für Dateien und andere Content-Items. Das Dossier hat eine hohe Priorität und ist Teil des strategischen Ziels “Flexibles System”. Es gibt auch eine Issue in Gitlab, die auf dieses Dossier referenziert. In der Diskussion zu diesem Dossier wurde auch die Idee aufgebracht, das Konzept der Zuarbeit bei der Akquise von PROJEKT XY zu verwenden. In anderen Kommentaren wird auf das Dossier referenziert, um z.B. die Notwendigkeit von Zuarbeiten für bestimmte Anwendungsfälle zu diskutieren oder um die Idee der Zuarbeit als Lösung für bestimmte Probleme vorzustellen. Insgesamt zeigt sich, dass das Konzept der Zuarbeit ein wichtiges Thema in samarbeid ist und dass es Potential für weitere Anwendungsfälle und Verbesserungen gibt.”

Llama 3.3 70B (64k Tokens) “Das Dossier “Zuarbeit” ist ein Feedback-Konzept, das darauf abzielt, externe Nutzer in samarbeid einzubinden und gleichzeitig das Rechtemanagement zu verschlanken. Es ermöglicht, bestimmte Aufgaben oder Datenfelder für externe Nutzer freizugeben, ohne dass diese Zugriff auf die gesamte Instanz oder alle Daten haben. Das Konzept ist teilweise umgesetzt und hat eine hohe Priorität. Das Dossier enthält eine Dokumentation, die den aktuellen Stand und die Ziele des Konzepts beschreibt. Es gibt auch Kommentare und Diskussionen zu dem Dossier, in denen verschiedene Aspekte und Anforderungen besprochen werden. In den Volltextfeldern und Aufgaben, in denen das Dossier referenziert wird, gibt es verschiedene Anwendungsfälle und Szenarien, in denen die Zuarbeit verwendet werden kann. Dazu gehören die Verwaltung von Stundenzetteln, die Erstellung von Newslettern und die Durchführung von Veranstaltungen. Insgesamt zeigt sich, dass die Zuarbeit ein wichtiges Feature für samarbeid ist, um externe Nutzer einzubinden und die Zusammenarbeit zu verbessern. Es gibt jedoch noch offene Fragen und Anforderungen, die geklärt werden müssen, um das Konzept vollständig umzusetzen.

Beide Antworten sind durchaus korrekt – und gleichzeitig wirken sie etwas unpräzise und blumig. Es ist interessant zu sehen, dass beide Modell bei gleichem Kontext leicht unterschiedliche inhaltliche Schwerpunkte liefern.

Aber klar, Aufgaben zum Zusammenfassen sind schwer zu fassen. Auch zwei Autoren würden unterschiedliche Schwerpunkte bei der Zusammenfassung von großen Datenmengen setzen. Daher sind wir bei unseren Fragen auch konkretere geworden und stellten die Frage: „Was sind Josefine Becks Aufgaben in Bezug auf die Zuarbeit?“. Und dabei haben wir die folgenden Antworten erhalten:

Llama 3.1 405B (64k Tokens) „Josefine Beck ist für die Aufgabe ‚Demonstration durchführen und dokumentieren‘ im Prozess ‚Demonstration samarbeid‘ verantwortlich. In dieser Aufgabe wird die Zuarbeit als ein wichtiger Aspekt erwähnt, der während der Demonstration diskutiert wurde. Außerdem ist Josefine Beck Teilnehmerin der Aufgabe ‚Konzept-Kaffee Zuarbeit‘ im Prozess ‚Wrap-Up‘, bei der es um die Konzeption und Umsetzung der Zuarbeit geht.“

Llama 3.3 70B (64k Tokens) „Josefine Beck ist Teilnehmerin des Konzept-Kaffees ‚Zuarbeit‘ und hat damit die Aufgabe, die Zuarbeit soweit auszuspezifizieren, dass mit der Implementierung begonnen werden kann.“

Auch hier sind beide Antworten durchaus korrekt – und gleichzeitig unterschiedlich detailliert.

Natürlich haben wir uns noch viel mehr Antworten auf unterschiedliche Fragen und Aufforderungen – zu unterschiedlichen Dossiers angeschaut. Die Ergebnisse sind bestimmt noch ausbaufähig. Aber trotzdem zeigen uns sie Experimente, dass es ein großes Potential für die Nutzung der eigenen privaten Daten in samarbeid gibt.

Unsere Schlüsselerkenntnisse sind:

- Bei beiden Modellen sollte die Präzision der Antworten verbessert werden.

- Das 405B-Modell liefert sehr detaillierte Antworten, benötigt aber enorme Rechenleistung.

- Das 70B-Modell ist wesentlich kleiner, bietet aber dennoch gute Antworten und kann auf erschwinglicher Server-Hardware betrieben werden.

Sprachmodelle und samarbeid: nächste Schritte & Zukunftspläne

Unsere Experimente zur Verbindung von samarbeid mit Open-Source-Sprachmodellen haben aus unserer Sicht vielversprechende Ergebnisse gezeigt. Wir werden weiter daran arbeiten, KI-Features datenschutzkonform in samarbeid zu integrieren. Bevor wir diese Feature jedoch für alle verfügbar machen können, braucht es noch weitere Schritte. Wir haben uns für die kommenden Monate folgendes vorgenommen:

- Verfeinerung der Kontextgenerierung. Unser aktueller Ansatz der Kontextgenerierung ist generisch, d.h. egal welche Frage oder Aufforderung an das Sprachmodell gestellt wird, wir generieren den Kontext immer auf die selbe Art und Weise. Um die Antwortgenauigkeit zu verbessern brauchen wir intelligentere Methoden der Kontextgenerierung. Wir können uns vorstellen, dass samarbeid in einer Art Ping-Pong gemeinsam mit dem Sprachmodell den passenden Kontext für die aktuelle Anfrage erstellt.

- Test neuer Open-Source-LLMs. Mit DeepSeek R1 hat ein neuer Player die Bühne betreten, den wir uns auch genauer anschauen sollten. Und dabei wird es nicht bleiben, das Feld der Open-Source-Sprachmodelle wird größer und vielfältiger und wir sollten schauen, was am Besten zur Nutzung in samarbeid und kleinen Organisationen passt,

- Identifikation von konkreten Einsatzfeldern. Wir haben jetzt Sprachmodelle in samarbeid mit sehr einfachen Aufgaben ausprobiert. Doch für was können wir die Sprachmodelle eigentlich genau einsetzen? Was sind die konkreten Einsatzfelder? Hier wollen wir Ideen sammeln – und sind auch sehr auf Input von euch gespannt.

- Einbindung in samarbeid als experimentelle Funktion. Natürlich wollen wir so schnell wie möglich die Funktion auch für euch verfügbar machen. Dabei geht es um die Frage, wie man die Sprachmodelle (und deren Bezahlung) gut mit samarbeid verbinden kann. Und natürlich darum, an welcher Stelle im UI KI-Feature schnell Nutzen für euch bringen können.

Fazit

Mit der Nutzung von Open-Source-Sprachmodellen in haben wir die Chance, dass ihr in Zukunft leichter und schneller die richtigen Informationen findet und sie direkt in euren Aufgaben nutzen könnt. Unsere Tests zeigen: Moderne Sprachmodelle liefern bereits auf günstiger Hardware beeindruckende Ergebnisse. Besonders vielversprechend ist der RAG-Ansatz, mit dem ihr eure eigenen Organisationsdaten sicher in die Konversation mit dem Sprachmodell einbinden könnt. Unser Fazit: Wir sind zuversichtlich, dass wir euch in Zukunft die Vorteile von Sprachmodellen bieten können – ohne Kompromisse bei der Datensouveränität einzugehen.

Möchtet ihr es selbst in eurem samarbeid ausprobieren?

Wir starten demnächst ein Beta-Programm für ‚Samarbeid Chat‘, bei dem ausgewählte Nutzer KI-gestützte Antworten in ihrer eigenen Samarbeid-Instanz testen können. Wenn ihr Interesse habt, meldet euch bei bei uns und fordert den Zugang an!

Vielen Dank an Bernd ? Dittrich für das Beitragsbild.